1. 개요

TensorFlow Lite 및 Firebase를 사용한 텍스트 분류 Codelab에 오신 것을 환영합니다. 이 Codelab에서는 TensorFlow Lite와 Firebase를 사용하여 텍스트 분류 모델을 학습시키고 앱에 배포하는 방법을 알아봅니다. 이 Codelab은 이 TensorFlow Lite 예를 기반으로 합니다.

텍스트 분류는 콘텐츠에 따라 텍스트에 태그 또는 카테고리를 할당하는 프로세스입니다. 감정 분석, 주제 라벨 지정, 스팸 감지, 의도 감지와 같은 광범위한 애플리케이션이 있는 자연어 처리(NLP)의 기본 작업 중 하나입니다.

감정 분석은 텍스트 분석 기술을 사용하여 텍스트 데이터 내의 감정 (긍정적, 부정적, 중립적)을 해석하고 분류하는 것입니다. 감정 분석을 통해 비즈니스는 온라인 대화 및 의견에서 제품, 브랜드 또는 서비스에 대한 고객의 감정을 파악할 수 있습니다.

이 튜토리얼에서는 특히 텍스트를 긍정 또는 부정으로 분류하는 감정 분석을 위한 머신러닝 모델을 빌드하는 방법을 보여줍니다. 이것이 머신러닝 문제에서 널리 적용되는 중요한 일종인 이진 분류, 즉 2등급 분류의 예입니다.

학습할 내용

- TF Lite Model Maker로 TF Lite 감정 분석 모델 학습시키기

- TF Lite 모델을 Firebase ML에 배포하고 앱에서 액세스

- TF Lite 작업 라이브러리를 사용하여 TF Lite 감정 분석 모델을 앱에 통합

필요한 사항

- 최신 Android 스튜디오 버전

- 샘플 코드

- Android 5.0 이상 및 Google Play 서비스 9.8 이상을 실행하는 테스트 기기 또는 Google Play 서비스 9.8 이상이 설치된 에뮬레이터

- 기기를 사용하는 경우 연결 케이블

본 튜토리얼을 어떻게 사용하실 계획인가요?

Android 앱 빌드 경험을 평가해 주세요.

2. 샘플 코드 가져오기

명령줄에서 GitHub 저장소를 클론합니다.

$ git clone https://github.com/FirebaseExtended/codelab-textclassification-android.git

git이 설치되어 있지 않으면 GitHub 페이지 또는 이 링크를 클릭하여 샘플 프로젝트를 다운로드할 수도 있습니다.

3. 시작 앱 가져오기

Android 스튜디오의 샘플 코드 다운로드 ( File > Open > .../codelab-textclassification-android-master/start)에서 codelab-textclassification-android-master 디렉터리 ( )를 선택합니다.

)를 선택합니다.

이제 Android 스튜디오에서 시작 프로젝트가 열려 있어야 합니다.

4. 시작 앱 실행

이제 프로젝트를 Android 스튜디오로 가져왔으므로 앱을 처음으로 실행할 수 있습니다. Android 기기를 연결하고 Android 스튜디오 툴바에서 Run( )을 클릭합니다.

)을 클릭합니다.

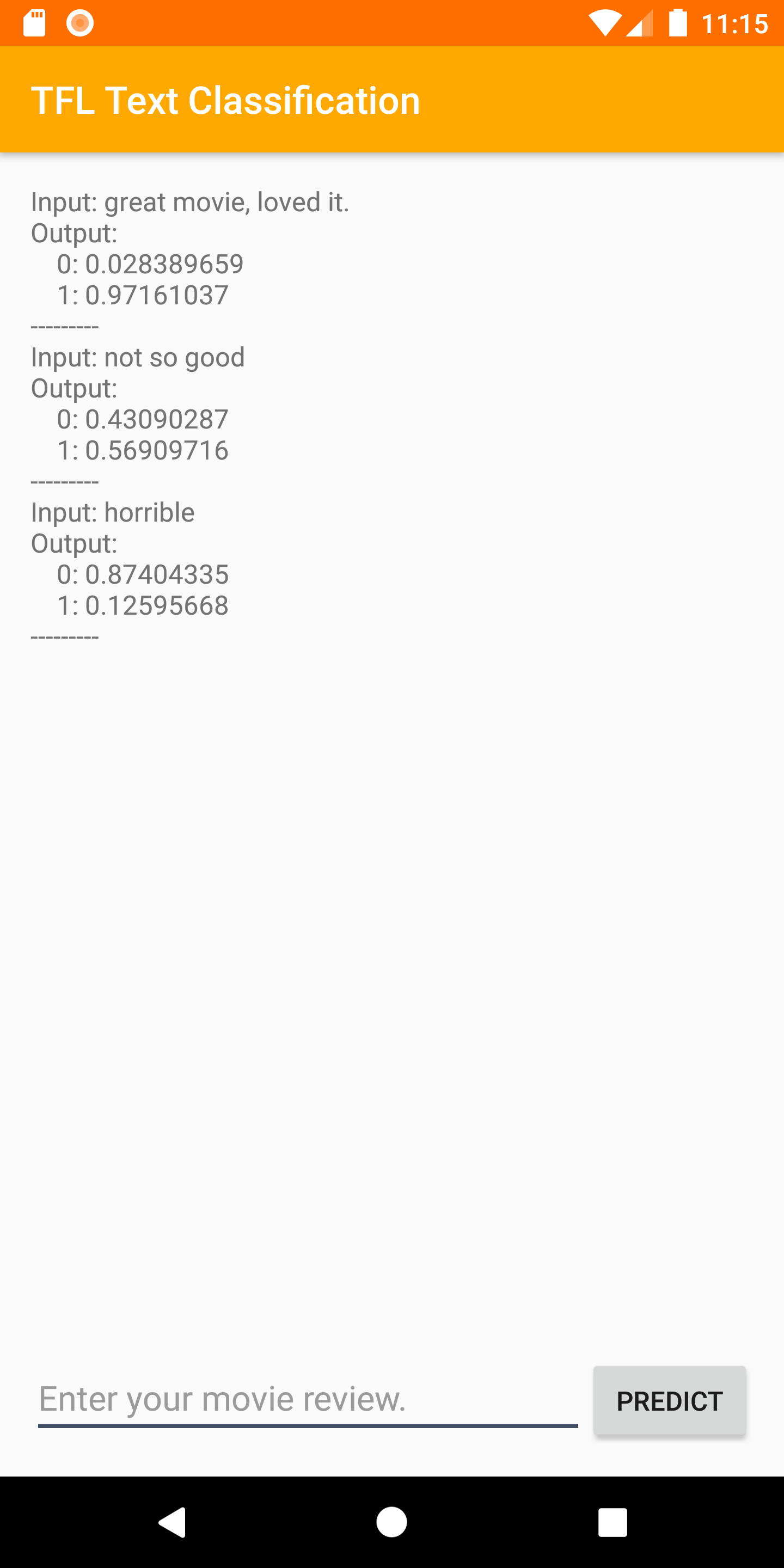

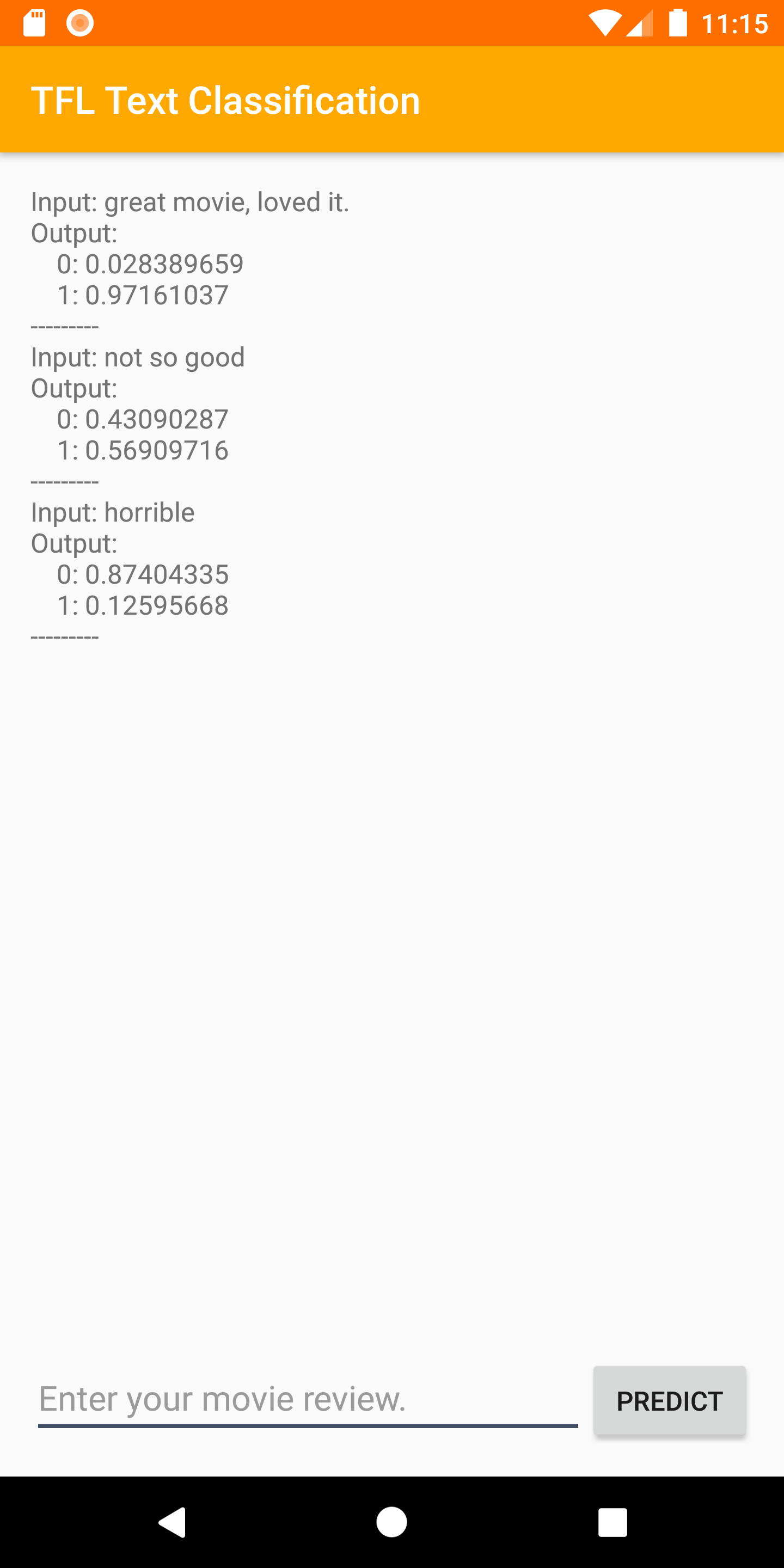

기기에서 앱이 실행됩니다. 다음 단계에서 텍스트 분류 모델을 쉽게 통합하고 테스트할 수 있는 간단한 UI만 포함되어 있습니다. 이 시점에서 감정을 예측하려고 하면 앱에서 일부 더미 결과만 반환합니다.

5. Firebase Console 프로젝트 만들기

프로젝트에 Firebase 추가

- Firebase Console로 이동합니다.

- 프로젝트 추가를 선택합니다.

- 프로젝트 이름을 선택하거나 입력합니다.

- Firebase Console에서 나머지 설정 단계를 따른 다음 프로젝트 만들기 (또는 기존 Google 프로젝트를 사용하는 경우 Firebase 추가)를 클릭합니다.

6. 앱에 Firebase 추가

- 새 프로젝트의 개요 화면에서 Android 아이콘을 클릭하여 설정 워크플로를 시작합니다.

- Codelab의 패키지 이름(

org.tensorflow.lite.codelabs.textclassification)을 입력합니다.

앱에 google-services.json 파일 추가

패키지 이름을 추가하고 등록**을 선택한 후 google-services.json 다운로드** 를 클릭하여 Firebase Android 구성 파일을 가져온 다음 google-services.json 파일을 프로젝트의 *app* 디렉터리에 복사합니다.

앱에 google-services 플러그인 추가

Firebase Console의 안내에 따라 build.gradle.kts 파일을 업데이트하여 Firebase를 앱에 추가합니다.

google-services 플러그인은 google-services.json 파일을 사용하여 Firebase를 사용하도록 애플리케이션을 구성합니다.

gradle 파일로 프로젝트 동기화

앱에서 모든 종속 항목을 사용할 수 있도록 하려면 이 시점에서 프로젝트를 Gradle 파일과 동기화해야 합니다. 파일 > Android 스튜디오 툴바에서 프로젝트 동기화를 클릭합니다.

7. Firebase로 앱 실행

이제 JSON 파일로 google-services 플러그인을 구성했으므로 Firebase로 앱을 실행할 준비가 되었습니다. Android 기기를 연결하고 Android 스튜디오 툴바에서 Run( )을 클릭합니다.

)을 클릭합니다.

기기에서 앱이 실행됩니다. 이 시점에서도 앱은 계속해서 정상적으로 빌드됩니다.

8. 감정 분석 모델 학습

TensorFlow Lite Model Maker를 사용하여 텍스트 분류 모델을 학습시켜 특정 텍스트의 감정을 예측해 보겠습니다.

이 단계는 Google Colab에서 열 수 있는 Python 노트북으로 제공됩니다. 런타임 > 모두 실행을 클릭하여 모든 노트북을 한 번에 실행합니다.

Colab에서 열기

이 단계를 완료하면 모바일 앱에 배포할 준비가 된 TensorFlow Lite 감정 분석 모델이 생성됩니다.

9. Firebase ML에 모델 배포

Firebase ML에 모델을 배포하는 것은 다음 두 가지 주요 이유로 유용합니다.

- 앱 설치 크기를 작게 유지하고 필요한 경우에만 모델을 다운로드할 수 있습니다.

- 모델은 전체 앱과는 다른 출시 주기로 정기적으로 업데이트할 수 있습니다.

모델은 Firebase Admin SDK를 사용하여 콘솔을 통해 또는 프로그래매틱 방식으로 배포할 수 있습니다. 이 단계에서는 콘솔을 통해 배포합니다.

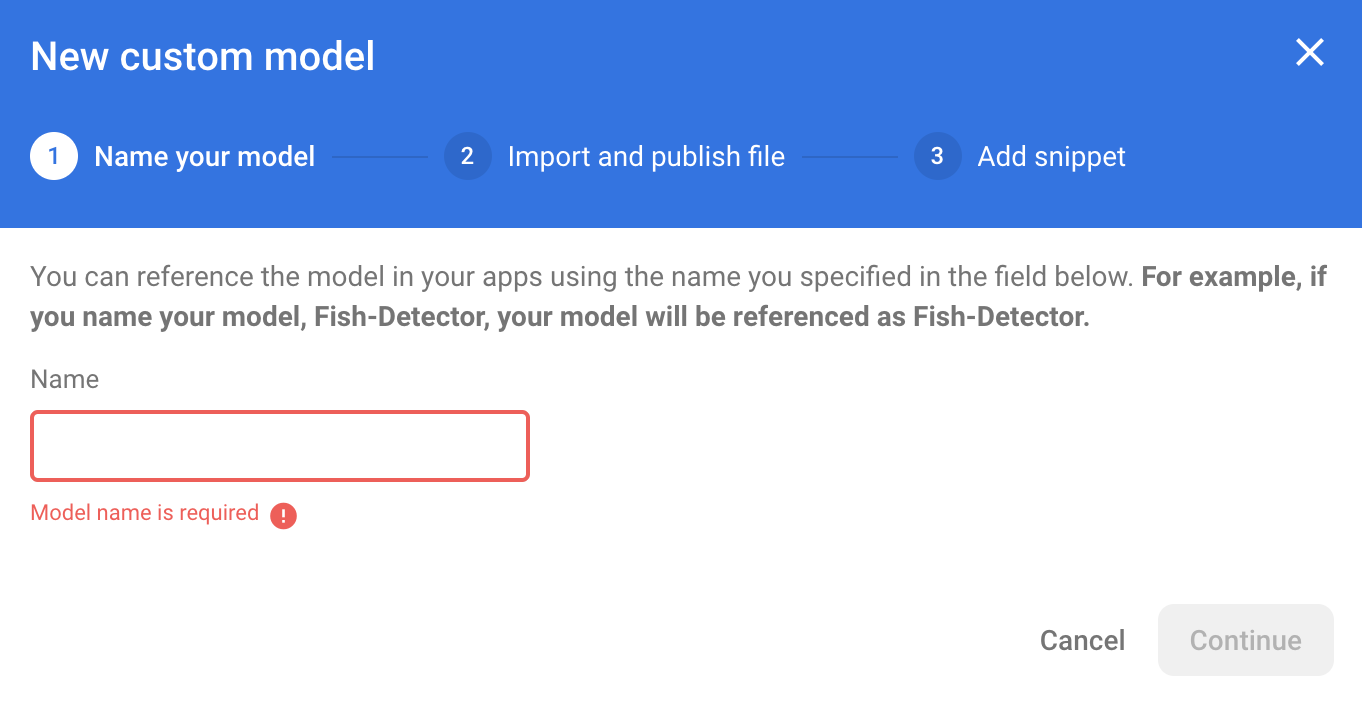

먼저 Firebase Console을 열고 왼쪽 탐색 패널에서 머신러닝을 클릭합니다. '시작하기'를 클릭합니다. 확인할 수 있습니다 그런 다음 '맞춤'으로 이동하여 '모델 추가' 버튼을 클릭합니다.

메시지가 표시되면 모델 이름을 sentiment_analysis로 지정하고 이전 단계에서 Colab에서 다운로드한 파일을 업로드합니다.

10. Firebase ML에서 모델 다운로드

TFLite 모델이 상대적으로 커질 수 있으므로 Firebase에서 앱으로 원격 모델을 다운로드할 시기를 선택하는 것은 까다로울 수 있습니다. 앱이 실행될 때 바로 모델을 로드하지 않는 것이 좋습니다. 모델이 하나의 기능에만 사용되고 사용자가 해당 기능을 사용하지 않으면 아무 이유 없이 상당한 양의 데이터를 다운로드하게 되기 때문입니다. Wi-Fi에 연결되어 있을 때만 모델을 가져오는 등의 다운로드 옵션을 설정할 수도 있습니다. 네트워크 연결 없이도 모델을 사용할 수 있도록 하려면 앱이 없어도 백업으로 모델을 번들로 묶는 것이 중요합니다.

여기서는 편의상 기본 번들 모델을 삭제하고 앱을 처음 시작할 때 항상 Firebase에서 모델을 다운로드합니다. 이렇게 하면 감정 분석을 실행할 때 Firebase에서 제공된 모델로 추론이 실행되고 있는지 확인할 수 있습니다.

app/build.gradle.kts 파일에 Firebase 머신러닝 종속 항목을 추가합니다.

app/build.gradle.kts

다음 댓글을 찾습니다.

// TODO 1: Add Firebase ML dependency

그런 다음 다음을 추가합니다.

implementation(platform("com.google.firebase:firebase-bom:32.0.0"))

implementation("com.google.firebase:firebase-ml-modeldownloader:24.1.2")

Android 스튜디오에서 프로젝트를 동기화하라는 메시지가 표시되면 Sync Now를 선택합니다.

그런 다음 Firebase에서 모델을 다운로드하는 코드를 추가해 보겠습니다.

MainActivity.java에서

이 댓글 찾기:

// TODO 2: Implement a method to download TFLite model from Firebase

그런 다음 다음을 추가합니다.

/** Download model from Firebase ML. */

private synchronized void downloadModel(String modelName) {

CustomModelDownloadConditions conditions = new CustomModelDownloadConditions.Builder()

.requireWifi()

.build();

FirebaseModelDownloader.getInstance()

.getModel("sentiment_analysis", DownloadType.LOCAL_MODEL, conditions)

.addOnSuccessListener(model -> {

try {

// TODO 6: Initialize a TextClassifier with the downloaded model

predictButton.setEnabled(true);

} catch (IOException e) {

Log.e(TAG, "Failed to initialize the model. ", e);

Toast.makeText(

MainActivity.this,

"Model initialization failed.",

Toast.LENGTH_LONG)

.show();

predictButton.setEnabled(false);

}

})

.addOnFailureListener(e -> {

Log.e(TAG, "Failed to download the model. ", e);

Toast.makeText(

MainActivity.this,

"Model download failed, please check your connection.",

Toast.LENGTH_LONG)

.show();

}

);

}

그런 다음 활동의 onCreate 메서드에서 downloadModel 메서드를 호출합니다.

MainActivity.java에서

이 댓글 찾기:

// TODO 3: Call the method to download TFLite model

그런 다음 다음을 추가합니다.

downloadModel("sentiment_analysis");

11. 앱에 모델 통합

TensorFlow Lite 작업 라이브러리를 사용하면 단 몇 줄의 코드로 TensorFlow Lite 모델을 앱에 통합할 수 있습니다. Firebase에서 다운로드한 TensorFlow Lite 모델을 사용하여 NLClassifier 인스턴스를 초기화합니다. 그런 다음 이를 사용하여 앱 사용자의 텍스트 입력을 분류하고 결과를 UI에 표시합니다.

종속 항목 추가

앱의 Gradle 파일로 이동하여 앱의 종속 항목에 TensorFlow Lite Task Library (텍스트)를 추가합니다.

app/build.gradle

이 댓글 찾기:

// TODO 4: Add TFLite Task API (Text) dependency

그런 다음 다음을 추가합니다.

implementation("org.tensorflow:tensorflow-lite-task-text:0.3.0")

Android 스튜디오에서 프로젝트를 동기화하라는 메시지가 표시되면 Sync Now를 선택합니다.

텍스트 분류기 초기화

그런 다음 작업 라이브러리의 NLClassifier를 사용하여 Firebase에서 다운로드한 감정 분석 모델을 로드합니다.

MainActivity.java

NLClassifier 인스턴스 변수를 선언해 보겠습니다. 다음 댓글을 찾습니다.

// TODO 5: Define a NLClassifier variable

그런 다음 다음을 추가합니다.

private NLClassifier textClassifier;

Firebase에서 다운로드한 감정 분석 모델로 textClassifier 변수를 초기화합니다. 다음 댓글을 찾습니다.

// TODO 6: Initialize a TextClassifier with the downloaded model

그런 다음 다음을 추가합니다.

textClassifier = NLClassifier.createFromFile(model.getFile());

텍스트 분류

textClassifier 인스턴스가 설정되면 단일 메서드 호출로 감정 분석을 실행할 수 있습니다.

MainActivity.java에서

이 댓글 찾기:

// TODO 7: Run sentiment analysis on the input text

그런 다음 다음을 추가합니다.

List<Category> results = textClassifier.classify(text);

후처리 구현

마지막으로 모델의 출력을 화면에 표시할 설명 텍스트로 변환합니다.

MainActivity.java에서

이 댓글 찾기:

// TODO 8: Convert the result to a human-readable text

더미 결과 텍스트를 생성하는 코드를 삭제합니다.

String textToShow = "Dummy classification result.\n";

그런 다음 다음을 추가합니다.

String textToShow = "Input: " + text + "\nOutput:\n";

for (int i = 0; i < results.size(); i++) {

Category result = results.get(i);

textToShow += String.format(" %s: %s\n", result.getLabel(),

result.getScore());

}

textToShow += "---------\n";

12. 최종 앱 실행

감정 분석 모델을 앱에 통합했으므로 테스트해 보겠습니다. Android 기기를 연결하고 Android 스튜디오 툴바에서 Run( )을 클릭합니다.

)을 클릭합니다.

사용자가 입력한 영화 리뷰에 대한 감정을 앱에서 정확하게 예측할 수 있어야 합니다.

13. 더 많은 Firebase 기능으로 앱 역량 강화

Firebase는 TFLite 모델을 호스팅하는 것 외에도 머신러닝 사용 사례를 강화하는 몇 가지 다른 기능을 제공합니다.

- Firebase Performance Monitoring: 사용자 기기에서 실행되는 모델 추론 속도를 측정합니다.

- Firebase Analytics로 사용자 반응을 측정하여 프로덕션 환경에서 모델의 성능을 측정합니다.

- 여러 버전의 모델을 테스트하기 위한 Firebase A/B 테스팅

- 앞서 TFLite 모델의 두 가지 버전을 학습시킨 것을 기억하시나요? A/B 테스트는 프로덕션 환경에서 어떤 버전이 더 우수한 실적을 내는지 확인할 수 있는 좋은 방법입니다.

앱에서 이러한 기능을 활용하는 방법을 자세히 알아보려면 아래 Codelab을 확인하세요.

14. 수고하셨습니다.

이 Codelab에서는 감정 분석 TFLite 모델을 학습시키고 Firebase를 사용하여 모바일 앱에 배포하는 방법을 알아보았습니다. TFLite 및 Firebase에 대해 자세히 알아보려면 다른 TFLite 샘플 및 Firebase 시작 가이드를 참고하세요.

학습한 내용

- TensorFlow Lite

- Firebase ML

다음 단계

- Firebase Performance Monitoring으로 모델 추론 속도를 측정합니다.

- Firebase ML Model Management API를 통해 Colab에서 Firebase로 모델을 직접 배포합니다.

- 사용자가 예측 결과에 대해 피드백을 제공할 수 있는 메커니즘을 추가하고 Firebase Analytics를 사용하여 사용자 피드백을 추적합니다.

- Firebase A/B 테스팅을 통해 평균 단어 벡터 모델과 MobileBERT 모델에 대한 A/B 테스트를 진행합니다.